Les modèles de langage actuels possèdent une connaissance encyclopédique du monde public, mais ils ignorent tout de votre entreprise. C'est le paradoxe de l'IA moderne. Vous avez accès à l'outil le plus puissant de la décennie, mais il est incapable de vous dire quel est le solde de congés de vos employés ou la spécificité technique de votre dernier produit. Pour transformer l’intelligence artificielle en levier de croissance réel, il est impératif de connecter ces modèles à vos propres données via le RAG, ou génération augmentée par récupération.

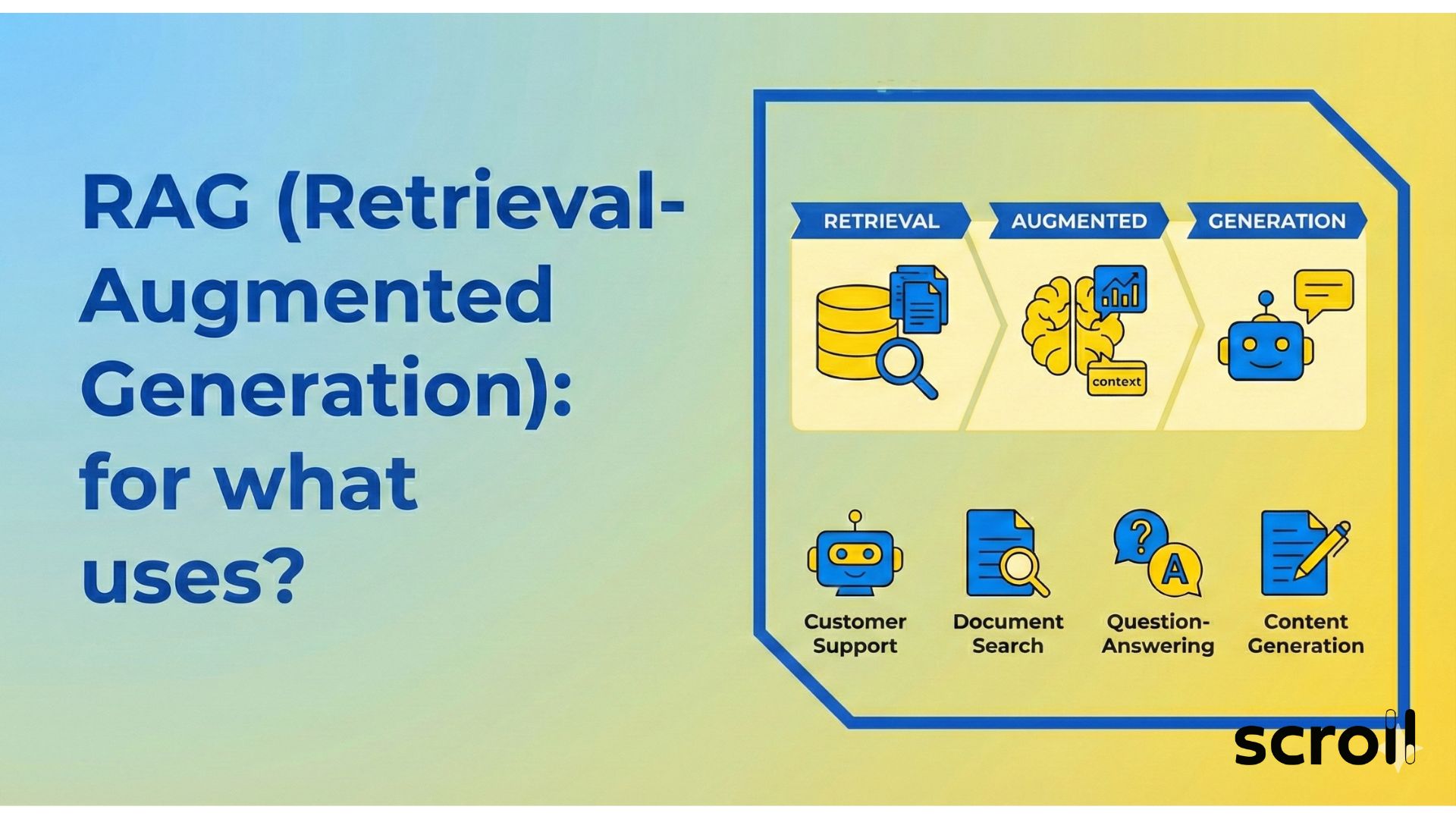

Qu'est-ce que le RAG (Génération Augmentée par Récupération) ?

Le Retrieval-Augmented Generation, souvent désigné par l'acronyme RAG, est une architecture technique qui optimise les résultats d'un grand modèle de langage (LLM) en lui donnant accès à une base de connaissances externe avant de générer une réponse. C'est le pont manquant entre la puissance linguistique de l'IA et la réalité opérationnelle de votre business.

Imaginez un examen à livre ouvert. Un LLM standard, comme GPT ou Claude, passe l'examen uniquement avec ce qu'il a appris lors de son entraînement initial. S'il ne connaît pas la réponse, il risque d'inventer des faits de manière convaincante pour satisfaire la demande. C'est ce qu'on appelle une hallucination. Avec une architecture RAG, l'IA a le droit d'aller chercher l'information dans un manuel de référence fiable, qui correspond à vos données, avant de rédiger sa copie.

Cette approche comble les deux lacunes majeures du traitement du langage naturel traditionnel. Premièrement, elle résout le problème de l'obsolescence des données, car le modèle n'est pas figé dans le temps. Deuxièmement, elle apporte le contexte privé manquant. En connectant l'IA générative à vos données externes, vous transformez un outil généraliste en un expert de votre métier.

5 Cas d'usage entreprise où le RAG est indispensable

L'adoption du RAG ne se limite pas à de la simple innovation technologique. C'est une réponse concrète à des besoins business de productivité et de fiabilité. Voici les domaines où cette technologie excelle et transforme les opérations.

Chatbots intelligents et Support Client augmenté

Le service client est le terrain de jeu historique des tentatives d'automatisation, souvent avec des résultats décevants par le passé. L'intégration de chatbots intelligents propulsés par le RAG change radicalement la donne. Contrairement aux bots classiques basés sur des arbres de décision rigides qui frustrent les clients, un assistant RAG comprend l'intention de l'utilisateur et puise dans la documentation technique, l'historique des tickets et les bases de connaissances produits pour formuler sa réponse.

La précision des réponses est ici le facteur clé. Le système ne se contente pas de rediriger vers une page FAQ générique. Il synthétise la solution exacte au problème du client en temps réel. Cela améliore considérablement l'expérience utilisateur tout en désengorgeant les équipes support des requêtes de niveau 1. De plus, l'optimisation des réponses IA permet d'adapter le ton et la complexité de la réponse selon le profil de l'interlocuteur, qu'il soit un novice ou un expert technique.

Exploitation de la documentation d'entreprise

La majorité des connaissances d'une entreprise dort dans des silos inaccessibles comme des PDF, des Intranets, des Sharepoints ou des comptes Notion. La recherche par mot-clé classique dans ces environnements est souvent inefficace car elle oblige le collaborateur à connaître le terme exact présent dans le document. Le RAG permet l'exploitation des données internes en langage naturel.

Un collaborateur peut désormais poser une question complexe telle que "Quelle est la procédure de validation des notes de frais pour un déplacement hors UE avec un client VIP ?" et obtenir une réponse synthétisée. Cette capacité à dialoguer avec la documentation d'entreprise génère des gains de productivité massifs. On passe d'une logique de recherche de documents, qui prend du temps, à une logique de recherche d'information ciblée et immédiate.

Aide à la décision et Analyse Juridique

Dans les secteurs réglementés comme le droit, la finance ou l'assurance, la moindre erreur peut coûter cher. La fiabilité des réponses est non négociable. L'utilisation du RAG permet d'assurer un ancrage factuel fort. Lorsqu'un juriste interroge une base de contrats via une architecture RAG, le modèle génère sa réponse en citant explicitement les clauses et les articles sur lesquels il s'appuie.

Cette traçabilité permet une vérification humaine rapide et instaure une confiance nécessaire envers les systèmes hybrides IA. L'outil ne remplace pas l'expert, il augmente ses capacités d'analyse en traitant des volumes de données qu'un humain ne pourrait pas absorber en un temps raisonnable. C'est un assistant de recherche infatigable qui pré-mâche le travail d'analyse.

Onboarding et Formation des collaborateurs

L'intégration des nouveaux talents est un processus coûteux en temps pour les managers et les RH. Un assistant virtuel basé sur le RAG peut servir de mentor disponible 24h/24 pour les nouvelles recrues. Il répond aux questions sur la culture d'entreprise, les processus internes ou l'utilisation des outils métier en se basant sur les sources d’informations fiables validées par les RH.

Cela garantit que l'information transmise est toujours à jour, contrairement aux livrets d'accueil statiques qui deviennent obsolètes dès leur impression. La mise à jour des connaissances se fait simplement en ajoutant les nouveaux documents de politique interne dans la base vectorielle, sans nécessiter de réentraînement complexe ni d'intervention technique lourde.

Moteurs de recherche augmentés pour le E-commerce

Les moteurs de recherche augmentés représentent l'avenir de la navigation sur les sites e-commerce complexes ou les catalogues B2B volumineux. Plutôt que de filtrer par catégories, l'utilisateur peut exprimer un besoin fonctionnel : "Je cherche une solution de stockage compatible avec mon serveur modèle X qui optimise la consommation d'énergie".

Le système utilise la recherche sémantique pour comprendre les caractéristiques techniques et la compatibilité des produits, proposant ainsi des recommandations pertinentes qui vont au-delà de la simple correspondance de mots-clés. C'est une application directe de la vectorisation des données pour améliorer la conversion et guider le client vers le bon produit sans friction.

Pourquoi choisir l'architecture RAG plutôt que le Fine-Tuning ?

C'est une question récurrente chez les décideurs techniques : faut-il réentraîner un modèle (Fine-Tuning) ou utiliser le RAG ? Si la comparaison RAG vs LLM finetuné mérite nuance, le RAG l'emporte dans la grande majorité des applications métier pour des raisons pragmatiques et économiques.

La première raison est financière. Les coûts d’entraînement des LLM pour leur apprendre de nouvelles connaissances sont prohibitifs et doivent être répétés à chaque changement de données significatif. Avec le RAG, l'intégration de données en temps réel est possible. Il suffit d'indexer le nouveau document pour qu'il soit immédiatement "connu" par le système. Cela offre une agilité que le Fine-Tuning ne peut égaler.

La seconde raison concerne la véracité. Le Fine-Tuning est efficace pour apprendre au modèle un style, un vocabulaire métier spécifique ou un format de réponse, mais il reste sujet aux hallucinations factuelles. Le modèle "pense" savoir, mais peut se tromper. Le RAG excelle dans la réduction des hallucinations car on contraint le modèle à répondre uniquement à partir du contexte fourni par les systèmes de récupération. Si l'information n'est pas dans les documents récupérés, le modèle est programmé pour dire "Je ne sais pas", plutôt que d'inventer une réponse plausible mais fausse.

Enfin, la comparaison RAG vs IA générative standard met en lumière la transparence. Le RAG permet de sourcer chaque phrase générée, offrant une auditabilité impossible avec un modèle "boîte noire" qui a simplement mémorisé des informations lors de son entraînement. Vous savez exactement pourquoi l'IA a donné cette réponse.

Fonctionnement technique : De la donnée brute à la réponse générée

Pour comprendre la puissance du RAG, il faut soulever le capot et observer le flux de données. Ce processus transforme une documentation inerte en une intelligence active via plusieurs étapes critiques qui demandent une expertise en ingénierie de la donnée.

Ingestion et Prétraitement des données

Tout commence par la collecte des documents depuis diverses sources. Le prétraitement des données est une étape souvent sous-estimée mais vitale pour la performance finale. Il s'agit de nettoyer les textes, de supprimer le bruit (en-têtes, pieds de page inutiles, balises HTML) et de découper l'information en morceaux digestes appelés "chunks". La qualité de ce découpage influence directement la pertinence des résultats futurs. Si les segments sont trop courts, on perd le contexte nécessaire à la compréhension. S'ils sont trop longs, on noie l'information précise dans du bruit.

Vectorisation et Bases de données vectorielles

Une fois le texte découpé, il passe par une étape de vectorisation des données (ou embedding). Des modèles spécialisés transforment ces morceaux de texte en vecteurs mathématiques, c'est-à-dire en longues suites de nombres qui représentent le sens sémantique du contenu dans un espace multidimensionnel. Ces vecteurs sont stockés dans des bases de données vectorielles comme Pinecone, Weaviate, Qdrant ou Milvus. Ces bases sont spécifiquement conçues pour effectuer des recherches de similarité ultra-rapides, bien plus performantes que les bases SQL classiques pour ce type de tâche.

Le mécanisme de Récupération (Retrieval)

Lorsque l'utilisateur pose une question, celle-ci est également vectorisée en temps réel par le même modèle d'embedding. Le système effectue alors une recherche sémantique dans la base vectorielle pour identifier les "chunks" de texte dont les vecteurs sont mathématiquement les plus proches de la question. C'est ici que la magie de la récupération d’informations opère : le système ne cherche pas les mêmes mots-clés, mais le même sens ou la même intention.

Génération Augmentée

Les fragments de texte les plus pertinents sont extraits et envoyés au LLM (comme GPT ou Claude) en même temps que la question de l'utilisateur, au sein d'une consigne structurée appelée "prompt". Le modèle de langage agit alors comme un processeur de synthèse intelligent : il lit les informations fournies dans le contexte et rédige une réponse fluide, cohérente et argumentée. C'est cette combinaison qui définit l'optimisation des réponses IA par le RAG.

Défis de sécurité et limites actuelles

Si le RAG est puissant, sa mise en œuvre exige une rigueur absolue, notamment sur la sécurité des données. L'un des pièges classiques est la gestion des droits d'accès. Si votre base vectorielle contient tous les documents de l'entreprise sans distinction, un stagiaire ne doit pas pouvoir demander au chatbot "Combien gagne le PDG ?" et obtenir la réponse extraite d'une fiche de paie confidentielle qui aurait été indexée par erreur.

La gestion des droits au niveau de la récupération d’informations est donc critique pour assurer la conformité RGPD et la confidentialité industrielle. Le système doit être capable de filtrer les documents accessibles par l'utilisateur avant même de les envoyer au LLM pour génération. Cela implique de synchroniser les métadonnées de sécurité de vos documents originaux avec la base vectorielle.

Un autre défi majeur réside dans la qualité des données sources. Le principe "Garbage In, Garbage Out" s'applique pleinement ici. Si votre documentation d’entreprise est contradictoire, obsolète ou mal structurée, le RAG produira des réponses incohérentes, quelle que soit la puissance du modèle sous-jacent. Une stratégie de gouvernance de la donnée est souvent le prérequis indispensable. Le succès d'un projet RAG dépend souvent à 80% de l'ingénierie des données et à 20% de l'IA elle-même.

Transformez vos données en intelligence active

Le retrieval augmented generation n'est plus une technologie expérimentale réservée aux laboratoires de recherche. C'est le standard industriel pour déployer des IA génératives utiles, fiables et sécurisées en entreprise. Il permet de valoriser votre patrimoine de données en le rendant accessible et exploitable instantanément par l'ensemble de vos collaborateurs.

Chez Scroll, nous ne nous contentons pas d'implémenter des briques techniques isolées. Nous concevons l'architecture complète, de l'audit initial de vos données à la mise en production de systèmes hybrides IA robustes et sécurisés. Si vous souhaitez transformer vos bases documentaires inertes en véritables leviers de performance, nous pouvons définir ensemble votre premier périmètre d'application.

Vous souhaitez une démonstration concrète de ce que le RAG peut faire sur vos propres données ? Contactez l'équipe Scroll pour planifier un audit préliminaire et découvrir le potentiel caché de vos informations.

Faq

Le RAG (ou génération augmentée par récupération) est une architecture qui combine la puissance d'un LLM (comme GPT) avec une base de connaissances externe. Contrairement à une IA classique qui se base uniquement sur son entraînement, le RAG va chercher des informations à jour dans vos données internes avant de formuler une réponse, garantissant ainsi pertinence et contexte.

Le Fine-Tuning consiste à réentraîner un modèle pour lui apprendre de nouvelles connaissances, ce qui implique des coûts d’entraînement des LLM élevés et une rigidité face au changement. Le RAG, à l'inverse, connecte le modèle à une base de données dynamique. Il est idéal pour la mise à jour des connaissances fréquente et pour l'ancrage factuel, car il ne nécessite pas de réentraînement pour assimiler une nouvelle information.

Les modèles de langage peuvent inventer des faits lorsqu'ils manquent d'informations. L'architecture RAG réduit drastiquement ce risque en obligeant l'IA à utiliser uniquement les sources d’informations fiables récupérées lors de la recherche. Si l'information n'est pas trouvée dans la base de données vectorielle, le système est configuré pour indiquer qu'il ne connaît pas la réponse, assurant ainsi une fiabilité des réponses maximale.

Oui, si l'architecture est bien conçue. Contrairement aux modèles publics où vos données peuvent servir à l'entraînement, un système RAG privé permet de garder le contrôle total. Vous pouvez gérer les droits d'accès au niveau de la récupération d’informations (un utilisateur ne voit que ce qu'il a le droit de voir) et assurer la conformité RGPD en hébergeant les données sur des serveurs sécurisés ou via des instances privées.

Le RAG est extrêmement flexible grâce à la vectorisation des données. Il permet l'exploitation des données internes sous presque toutes les formes textuelles : PDF techniques, contrats juridiques, pages Intranet, tickets de support, emails ou bases SQL. Une fois traitées par les systèmes de récupération, ces données non structurées deviennent une source de connaissance interrogeable en langage naturel.

.svg)

.jpg)

.svg)

.svg)

.svg)